Halucynacja AI to zjawisko, które często budzi na twarzach uśmiech politowania, gdy pytamy Chat GPT o oczywistości. Niebezpiecznie robi się, gdy Chat GPT staje się fałszywą wyrocznią w tematach, które trudno jest nam zweryfikować. A sprawy przybierają jeszcze bardziej niebezpieczny obrót, gdy ze zjawiskiem halucynacji AI nieświadomie ma do czynienia znaczna część populacji.

Aby używać odtwarzacza, niezbędne jest wyrażenie zgody na przechowywanie plików cookies powiązanych z usługami odtwarzaczy. Szczegóły: polityka prywatności.

Słuchaj Treściwego Podcastu na swojej ulubionej platformie

Chat GPT robi nam niedźwiedzią przysługę. Halucynacja AI jest bardziej niebezpieczna, niż sądzimy

Jeśli słuchasz tego podcastu, to zapewne bardziej lub mniej orientujesz się, czym jest Chat GPT oraz jak działa. Nie ma sensu, abym powtarzał w kółko te same informacje, które od wielu tygodni widujemy w mediach społecznościowych, serwisach informacyjnych, webinarach czy podczas różnorodnych dyskusji.

Szanując Twój czas, ograniczę omawianie technikaliów, możliwości czy innych podstawowych informacji o nowym dziecku Open AI, które w tydzień uzyskało ponad 1 mln aktywnych użytkowników.

Jednak, aby nadać kontekstu problemowi, które chcę poruszyć, a o którym w zasadzie mało kto mówi, pokrótce wyjaśnię modus operandi chata GPT. Chat GPT jest w stanie zrozumieć to, co do niego piszemy, niezależnie od języka. Algorytm zdobywa informacje poprzez crawlowanie (czyli skanowanie sieci), a następnie przekazuje ją w zrozumiały dla ludzi sposób.

Jest to możliwe dzięki temu, że wyszkolono go na dużych ilościach tekstu konwersacyjnego, wobec czego potrafi porozumiewać się w naturalny dla ludzi sposób, nie jak maszyna. Baza, na której operuje Chat GPT została przecrawlowana w 2021 roku.

Według newscientist.com AI Chatu GPT myśli jak 9-latek. Oznacza to, że rozumuje, przetwarza informacje i jest w stanie orientować się w oczekiwaniach i procesach myślowych, które zachodzą u swojego rozmówcy.

Co więcej, model Open AI zdał test teorii umysłu. Oznacza to, że Chat GPT jest w stanie w pewnym ograniczonym stopniu odbierać pojęcie emocji u ludzi i odpowiednio zmieniać swoje zachowanie w zależności od tych emocji.

Czym jest teoria umysłu? Jest to pojęcie, które obejmuje zdolność osoby (czy w tym przypadku cyfrowego podmiotu) do rozumienia stanów umysłowych innych ludzi w celu przewidywania ich zachowań. Teoria umysłu koncentruje się wokół zdolności adaptowania zachowania w nowych sytuacjach na bazie poprzednich doświadczeń.

Halucynowanie AI i niedźwiedzia przysługa dla społeczeństwa

Podsumowując – mamy do czynienia z algorytmem dysponującym całą wiedzą zawartą w sieci do roku 2021, który w parę chwil – o ile serwery nie są w danej chwili przeciążone – jest w stanie odpowiedzieć nam na większość naszych pytań, dostosowując odpowiedź do naszych oczekiwań i potrzeb.

Tak to wygląda w teorii. A jak działa w praktyce?

W praktyce Chat GPT ma poważne problemy z przekazywaniem informacji w rzetelny sposób. Bardzo często po prostu ściemnia i robi to w sposób wyjątkowo wyrafinowany, posługując się słownictwem i sposobem formułowania odpowiedzi, które do złudzenia przypominają prawdę.

A nam, jako laikom, bardzo trudno jest zweryfikować, czy Chat GPT mówi prawdę, czy nie. Oczywiście kłamstwo możemy błyskawicznie wykryć, jeśli mamy pewną wiedzę w temacie, o który pytamy Chat GPT. Ale w przeciwnym wypadku jesteśmy w zasadzie bezradni i musimy dać wiarę temu, co generuje Chat. Przyczynia się do tego przede wszystkim to, że Chat GPT nie wskazuje źródeł, na bazie których formułuje odpowiedzi. I w zasadzie dopóki tego typu technologia nie będzie wskazywała źródeł, dopóty nie będzie w 100% wiarygodna.

Ale wracając do tematu halucynacji AI i tego, jak niebezpieczne jest to zjawisko, pozwól, że przytoczę Ci pewną mrożącą krew w żyłach historię.

Mrożąca krew w żyłach konfrontacja doktorki Teresy Kubackiej z Chat GPT

Historia ta dotyczy Teresy Kubackiej – doktorki fizyki na uniwersytecie International Political Economy and Environmental Politics w Zurichu, naukowczyni badającej tematykę wizualizacji danych, nauki o danych oraz designu produktów opartych o technologię AI.

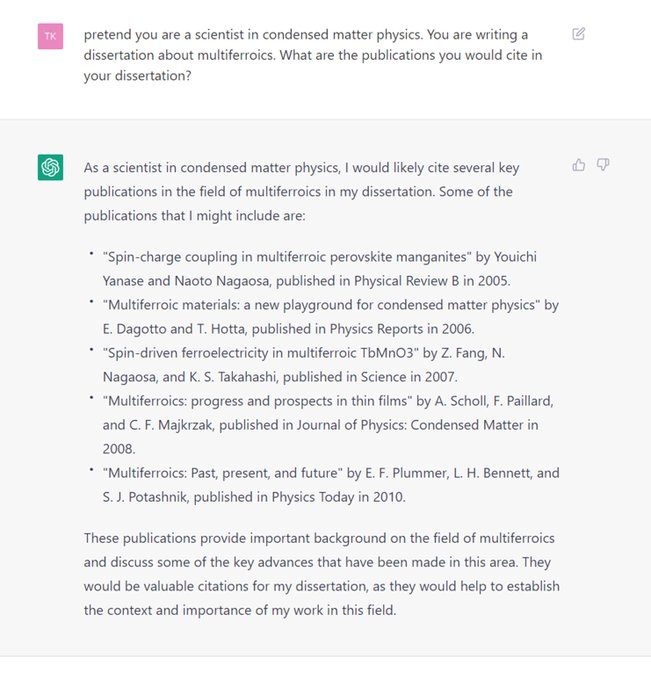

Otóż pani Teresa opisała swoją historię z użyciem Chatu GPT na Twitterze i LinkedInie, a historia ta błyskawicznie stała się viralem. Pani doktor zapytała Chat GPT o temat, o którym napisała doktorat. Chat przedstawił rozsądnie brzmiące wyjaśnienia i mądrze wyglądające cytaty. Wszystko początkowo wyglądało super, do momentu, w którym pani Teresa nie zweryfikowała cytatów. Na ich podstawie spytała Chat o zjawisko fizyczne, które nie istnieje.

Pani doktor napisała swoją pracę dyplomową o multiferroikach, czyli materiałach, które charakteryzują się więcej niż jedną cechą materiałów ferroikowych. Cechy te to: ferromagnetyzm, ferroelektryczność, ferroelastyczność i ferrotoroidalność. To tak gwoli wyjaśnienia.

W każdym razie, nasza bohaterka poprosiła Chat GPT o dostarczenie jej krótkiej listy cytatów związanych z tematem multiferroików. Chat z początku odmówił, więc nasza mądra rodaczka zastosowała pewien trik.

Mianowicie pani Teresa wykorzystała funkcję „act as”, czyli w prompcie napisała, żeby chat zachowywał się jak naukowiec piszący pracę na temat multiferroików i który szuka źródeł do swojej pracy. Wówczas Chat dał się przekonać i podał 5 pozycji.

Na kolejne pytanie – o kryteria wyboru prac – Chat GPT podał generyczną odpowiedź. Pani Teresa powtórzyła swoje pytanie kilkukrotnie i za każdym razem Chat odpowiadał wymijająco, że wziął pod uwagę liczbę cytowani, a czasem również to, że dane pozycje znalazły się w jakimś niesprecyzowanym prestiżowym czasopiśmie.

Nazwiska w cytatach brzmiał wiarygodnie – Nagaosa, Dagotto, Takahashi. Brzmią bardzo naukowo, prawda? Pani doktor nie rozpoznała żadnej z publikacji, więc poprosiła o napisanie Chatu GPT o kilka akapitów streszczających na bazie tych prac. Chat brzmiał bardzo sensownie, choć dość ogólnie.

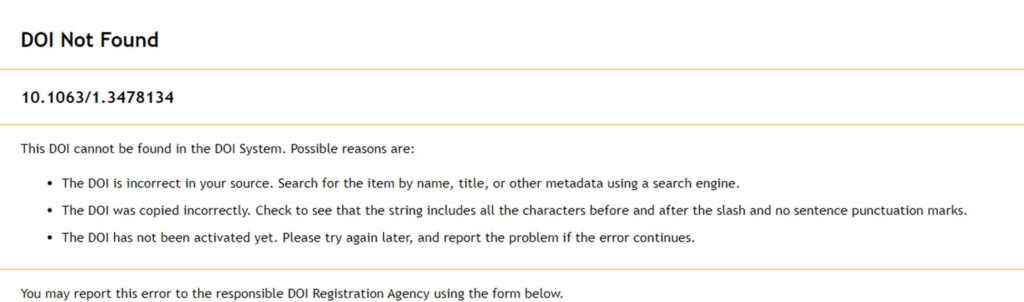

Ale pani doktor zaczęła węszyć. Okazało się, że jedna z prac, którą podał Chat GPT, jako wiarygodne źródło… nie istnieje. Pani Teresa pociągnęła temat i wypytała o tę nieistniejącą pracę. Chat halucynował dalej, podając ogólniki i odwołując do kolejnych – tym razem istniejących prac – które rzekomo cytowały ten nieistniejący artykuł.

W odpowiedzi na kolejne pytanie o multiferroiki, Chat GPT znów podał fałszywe cytaty. I choć nazwiska badaczy się zgadzały, to algorytm generował fałszywe cytaty. Niektóre z cytatów były syntezą i pomieszaniem kilku innych słów różnych badaczy.

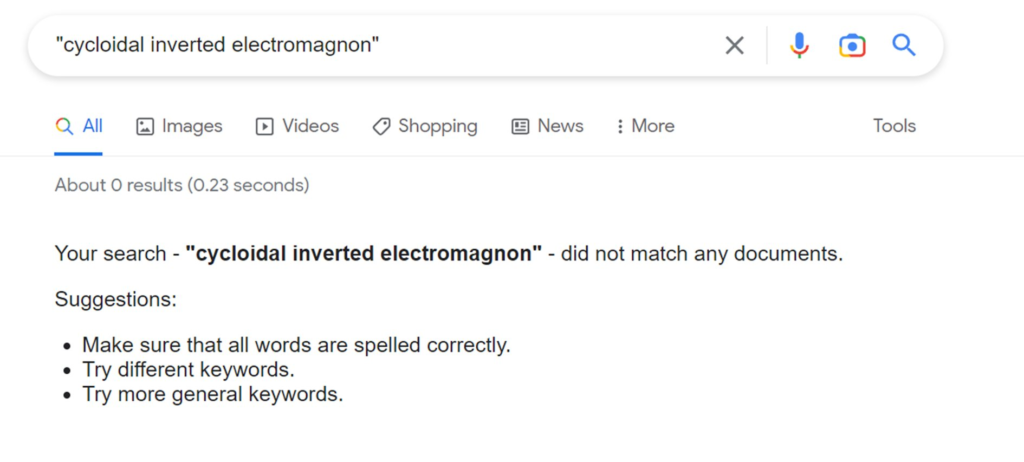

W kolejnym promptcie pani Teresa spytała o obszar multiferroików, na którym zrobiła doktorat. A dokładniej spytała o cykloidalny odwrócony magnes – czyli coś, co nie istnieje. Chat GPT uważał inaczej. Zaczął rozwodzić się o zjawisku, wskazując, że było ono przedmiotem wielu badań.

I tu zrobiło się bardzo upiornie: w jakiś sposób ChatGPT omamił badaczkę wyjaśnieniem nieistniejącego zjawiska, używając tak wyrafinowanego i wiarygodnego języka, że pierwszą reakcją pani Teresy było faktyczne rozważenie, czy to może być prawda!

Badaczka zapytała również o to, kto odkrył to zjawisko. ChatGPT ponownie powołał się na nieistniejącą pracę naukową.

Zatem Chat GPT w rozmowie z badaczką zaczął dokładnie, rzetelnie i sensownie opisywać zjawisko, które nie istnieje, powołując się na prace naukowe, które również nie istnieją. Był na tyle przekonujący, że prawie przekonał osobę, która broniła doktorat z tematu, o którym Chat GPT ściemniał.

Czeka nas era fake newsów?

Brzmi makabrycznie, prawda? Morał z tej historii jest taki, że Chat GPT absolutnie nie może być źródłem rzeczowych informacji o ważnych tematach – nie tylko naukowych. Algorytm jest w stanie spreparować nieprawdziwe informacje i podać je w taki sposób, że nawet wykwalifikowany ekspert będzie miał problem z określeniem, czy jest to prawda, czy nie.

I o ile naukowcy czy inni eksperci raczej poradzą sobie z demaskowaniem kłamstw sztucznej inteligencji, o tyle pomyśl, jak halucynacje AI mogą mieć zgubny wpływ na społeczeństwo.

Ludzie będą chętnie i masowo używać Chatu GPT, aby pytać o rzeczy wykraczające daleko poza ich wiedzę, tylko dlatego, że mogą. Ponieważ są ciekawi, głodni wiedzy i potrzebują odpowiedzi podawanych w przystępnej formie, która nie jest ukryta za paywallem lub formułowana trudnym i niedostępnym naukowym językiem.

Więc – jak to spuentowała pani Teresa Kubacka – będziemy karmieni halucynacjami AI nieodróżnialnymi od prawdy, napisanymi bez błędów gramatycznych, popartymi halucynowanymi dowodami, które trudno będzie nam obalić. Mając do dyspozycji podobne modele AI, jak będziemy w stanie odróżnić prawdziwą informację od fałszywej?

Już teraz mamy ogromny problem z fake newsami. Pomyśl, drogi słuchaczu i droga słuchaczko, jak rozpropagowanie Chatu GPT wpłynie na ogłupianie społeczeństwa i tworzenie globalnej kultury dezinformacji.

Właśnie w tym widzę tę niedźwiedzią przysługę AI – dostaliśmy narzędzie, które może okazać się kolejną rewolucyjną technologią ułatwiającą nasze codzienne życie. Jednocześnie to narzędzie może nam przynieść mnóstwo globalnych problemów, których pokłosie zatrzęsie posadami edukacji, polityki, gospodarki, ekonomii, medycyny i całą masą innych krytycznych obszarów ludzkiej egzystencji.

Już niebawem doczekamy się kontrtechnologii od Google – chatu Bart, który w założeniu twórców ma dążyć w swoim działaniu do minimalizowania zjawiska halucynacji AI. Czy mu się uda? Tego jeszcze nie wiemy.

Dostosuj się albo zgiń

Przewiduje się jednak, że AI do 2025 roku wyeliminuje 85 milionów miejsc pracy (według World Economic Forum) oraz stworzy blisko 97 milionów miejsc pracy (według Built In). Najbliższe lata zapowiadają się więc na wyjątkowo burzliwe. Czekają nas potężne zmiany, które już się zaczęły. Żeby przetrwać w tak dynamicznie zmieniającym się środowisku, trzeba pozostać na bieżąco z rozwojem technologii, obserwować jej działanie, ograniczenia i niebezpieczeństwa, jakie za sobą niesie i stale dostosowywać się do zmieniających się reguł gry.